Ein Schwerpunktthema im Mai ist das Thema „Fake News – Wie können wir Fake News besser erkennen. Doch wie kann uns die Forschung dabei helfen? Wir stellen einige spannende Forschungsprojekte zu diesem Thema vor.

Wir stellen diesmal Martin Boyer vom AIT – Austrian Institute of Technology vor. Er ist Experte für Softwarearchitektur im Bereich Videoanalyse und leitet das Projekt „defalsif-AI“.

Wie wird man Experte für Softwarearchitektur?

In meiner bisherigen beruflichen Laufbahn habe ich schon sehr unterschiedliche Jobs im Bereich der Software-Entwicklung in unterschiedlich großen Unternehmen ausgeübt. Dadurch habe ich Einblick in verschiedene Entwicklungsprozesse, komplexe Aufgabenstellungen, Systeme, Software-Projekte aber auch Qualitätsmanagement-Maßnahmen und Anforderungserhebung erhalten.

Als Experte für Softwarearchitektur bin ich „Mittler zwischen zwei Welten“. Die eine Welt ist die der AnwenderInnen bzw. AuftraggeberIinnen. Die andere Welt ist die der EntwicklerIinnen.

Beide Welten haben bestimmte Anforderungen und Bedürfnisse, denen es gerecht zu werden gilt. Man muss mit „beiden Welten“ reden können, um diese zu verbinden. Als Expertin oder Experte für Softwarearchitektur ist es wichtig, all diese Anforderungen und Bedürfnisse zu verstehen und über viel Erfahrung in der Software-Entwicklung und hinsichtlich aktuell verfügbarer Technologien zu verfügen.

Was haben Sie studiert?

Ich habe Elektronik an der Fachhochschule Technikum Wien studiert. Davor habe ich an der HTL Hollabrunn in der Abteilung für „Steuerungs- und Regelungstechnik“ maturiert.

Worum geht es bei dem Projekt defalsif-AI?

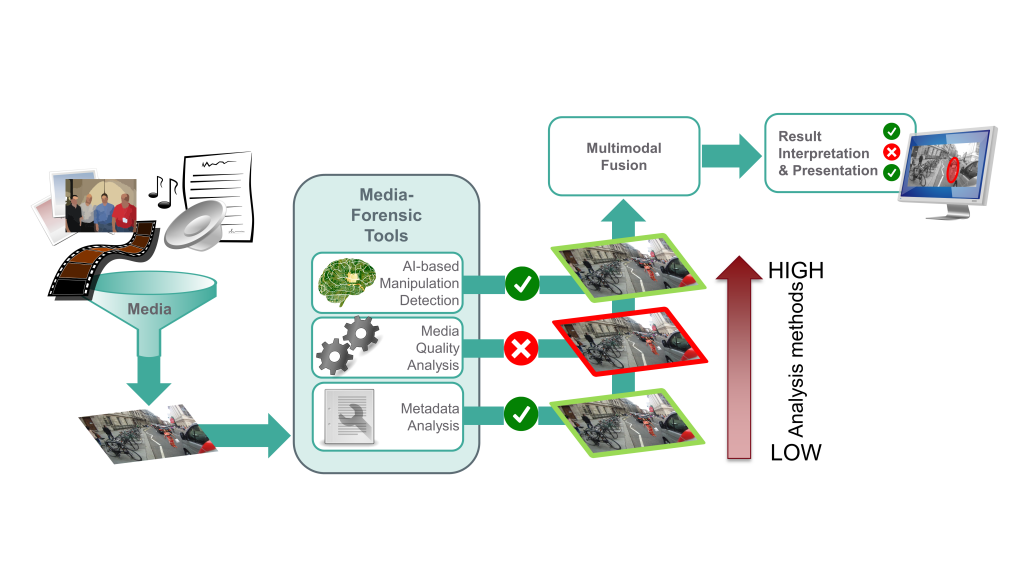

Ziel des Projekts ist es, ein Werkzeug für die Analyse von Texten, Bildern, Videos oder Audioaufzeichnungen im Internet zu erarbeiten. Dieses soll eine Empfehlung abgeben, ob man einem bestimmten Inhalt vertrauen kann – oder nicht.

Wir wollen dafür eine Vielzahl an unterschiedlichen Analyseverfahren und medienforensische Werkzeuge in einem gemeinsamen System zusammen führen.

Jedes einzelne dieser Analyseverfahren liefert für sich nachvollziehbare Ergebnisse, die in einer einheitlichen und verständlichen Benutzeroberfläche dargestellt werden.

Darüber hinaus wird diese Software aus rechts- und sozialwissenschaftlicher Perspektive beurteilt.

Das Forschungsprojekt „defalsif-AI“ (Detektion von Falschinformation mittels Artificial Intelligence) wird im Rahmen des österreichischen Sicherheitsforschungs-Förderprogrammes KIRAS gefördert.

Insgesamt 9 Projektpartner aus unterschiedlichen Bereichen sind an der gemeinsamen Umsetzung dieses Projekts beteiligt.

Das Projekt hat im Oktober 2020 begonnen und läuft noch bis September 2022.

Was genau sind medienforensische Werkzeuge?

Medienforensische Werkzeuge sind Softwareprogramme, die Manipulationen an Bildern, Videos, Audios oder Text erkennen können.

Ein Beispiel aus dem Bereich Bild/Video ist die automatische Erkennung, dass dieses Bild (LINK) manipuliert wurde. Oder dass dieses Video (LINK) künstlich erzeugt wurde.

Wie kann uns Künstliche Intelligenz (KI) bei der Überprüfung von Fake News unterstützen? Was kann man derzeit schon technisch umsetzen? Was wird die Forschung in der Zukunft in diesem Bereich leisten können?

KI ist der Versuch, menschliches Lernen und Denken auf den Computer zu übertragen. KIs können – in einem bestimmten Rahmen –selbstständig Probleme lösen.

Schon jetzt gibt es viele Methoden und Analyseverfahren, die es – auch unter Anwendung von Künstlicher Intelligenz – erlauben, bewusst und absichtsvoll in die Welt gesetzte Falschmeldungen zu erkennen.

Beispiele für solche Analyseverfahren sind Algorithmen, die Manipulationen in Bildern und Videos erkennen können – oder Algorithmen, welche in der Lage sind, künstlich erzeugte Texte zu identifizieren oder die geschürte Emotion zu bestimmen.

Einen „allumfassenden“ Fake News-Detektor gibt es nicht. Allerdings liegt sehr hohes Potenzial in der Kombination unterschiedlicher Verfahren, die an unterschiedlichen Modalitäten – Text, Bild, Video, Audio – arbeiten. Solche Systeme werden auch zukünftig von den wissenschaftlichen Fortschritten in den einzelnen Disziplinen, wie etwa der Bildverarbeitung oder dem Natural Language Processing, profitieren.

Wie schaut ein normaler Arbeitstag von Ihnen aus? Wie kann man sich die Forschungsarbeit mit den unterschiedlichsten Partnern in diesem Projekt wie APA oder ORF vorstellen?

Als Gesamtprojektleiter muss ich sowohl die organisatorische als auch die inhaltliche Arbeit im Projekt überblicken, abstimmen und koordinieren. Viele der Aufgaben bewältige ich nicht allein, sondern in Zusammenarbeit mit meinen Kolleginnen und Kollegen.

Ein „normaler Arbeitstag“ besteht meistens aus dem Lesen, Beantworten und Verfassen vieler Emails (ca. 50-100) bzw. der Teilnahme an 2 bis 3 Besprechungen oder Videokonferenzen mit firmeninternen und externen Partnern. Auch die Vorbereitung von Dokumenten und Präsentationen gehört dazu, genauso wie die Kontrolle der Einhaltung von Verträgen, der Verteilung von Fördergeldern, der Einhaltung von Deadlines und Zielen usw.

In Forschungsprojekten ist es besonders wichtig, dass die Kommunikation mit den Projektpartnern gut gelingt. Eines meiner wichtigsten Ziele ist, dass jedes Teammitglied stets wissen soll, mit welchen Anliegen und Fragestellungen man wen im Projekt befassen kann und wer einem bei einer Herausforderung weiterhelfen kann.

Das erleichtert die Arbeit Aller, gestattet ein effizientes Zusammenarbeiten als Team und ermöglicht die notwendige Kreativität und den Informationsaustausch für die Forschungsarbeit.

Wann werden uns technische Tools dabei unterstützen können, Fake News von glaubwürdigem und authentischem Text-, Bild-, Video- oder Audiomaterial im Internet zu unterscheiden?

Wie schon erwähnt, gibt es schon jetzt Methoden, die Menschen in einem bestimmten Rahmen dabei helfen, die Vertrauenswürdigkeit und Authentizität von Medieninhalten im Internet einzuschätzen.

Mit der Verfügbarkeit und Verständlichkeit dieser Methoden für eine „breite Anwenderschaft“ sieht es aber anders aus. Viele der Analyseverfahren erfordern viel technisches Know-how, um sie nutzen zu können. Auch die Interpretation der gelieferten Ergebnisse ist oft nicht einfach.

Dies ist eines der Hauptziele des Projekts defalsif-AI: dass das System auch von Nicht-Techniker*innen und Nicht-Expert*innen verstanden und benutzt werden kann – also einer breiten Nutzer*innen-Basis zur Verfügung steht. Dies fördert gut informierte und fundierte Entscheidungen und Diskussionen.

Vor welchen Herausforderungen stehen Sie?

Die Erarbeitung eines Systems, wie es im Projekt defalsif-AI entwickelt wird – ist immer auch eine Art „Katz-und-Maus-Spiel“: Die Fälscher*innen – also jene, die Fake News streuen und Medieninhalte manipulieren – reagieren auf die neuen Erkennungsmethoden, und das erschwert wiederum in Zukunft die Erkennung.

Daher ist es von Anfang an notwendig, dass die medienforensische Plattform es ermöglicht, bestehende und auch zukünftige Erkennungsmethoden auf einfache Weise zu integrieren. So werden den Anwender*innen auch in Zukunft zeitnah neue und aktualisierte Techniken zur Erkennung von Manipulationen zur Verfügung stehen.

Eine gute Softwarearchitektur hilft dabei, diese Herausforderung zu bewältigen und unser Ziel zu erreichen.

Blogbeitrag und Videobeitrag über Fake News

Der Verband für Elektrotechnik hat in Zusammenarbeit mit dem AIT-Austrian Institute of Technology einen Blogbeitrag über Fake News veröffentlicht.

Diesen Blogbeitrag kannst du auf der Website Lets Tech des OVE abrufen.

Der Videobeitrag von Martin Boyer zum Thema Fake News findest du auf Youtube (direkter Link zum Video)

Einen tollen Videobeitrag vom Wettbewerb “Science Forward” findest du auf der Youtube Plattform

APA Science hat ebenfalls einen tollen Beitrag zum Projekt defalsif-ai dazu veröffentlicht.